Deepfakes y Synthetic Media: ¿Qué deberíamos temer? ¿Qué podemos hacer?

Esta es la traducción al español del primero de una serie de blogs sobre una nueva área de enfoque en WITNESS sobre los emergentes y potenciales usos maliciosos de los llamados “deepfakes” y otras formas de medios sintéticos generados por IA y como respondemos para defender la evidencia, la verdad y la libertad de expresión. Compartiremos elementos ampliados del informe y más detalles sobre las recomendaciones en blogs separados: el segundo blog de la serie se puede encontrar aquí.

Este trabajo inició con una cumbre de personas expertas; el informe completo está disponible aquí.

Este trabajo forma parte de una iniciativa más amplia centrada en enfoques proactivos para proteger y defender las voces marginales y los derechos humanos a medida que las tecnologías emergentes como la inteligencia artificial se cruzan con las presiones de la desinformación, la manipulación de los medios y el autoritarismo en aumento.

La gente ha empezado a sentir pánico ante la posibilidad cada vez mayor de manipular imágenes, video y audio, a menudo, popularmente descrito como “deepfakes”. En la última década, los estudios de Hollywood han tenido la capacidad de transformar caras, desde -Brad Pitt en “El curioso caso de Benjamin Button” hasta Princesa Leia en “Star Wars ‘Rogue One”- y las empresas y consumidores han tenido herramientas como Photoshop para alterar imágenes y videos digitalmente de maneras más sutiles. Sin embargo, ahora las principales barreras para crear y manipular audio y video en formas múltiples y más sofisticadas están comenzando a disminuir, requiriendo menos costo, menos experiencia técnica y aprovechándose del poder de computación en la nube ampliamente disponible. Al mismo tiempo, la sofisticación de la manipulación de los espacios de redes sociales por parte de malhechores ha dado lugar a mayores oportunidades de convertir estas manipulaciones en armas.

Este panorama cambiante permite nuevos desafíos para los derechos humanos y el periodismo confiable que potencialmente incluye categorías de disrupción que incluyen:

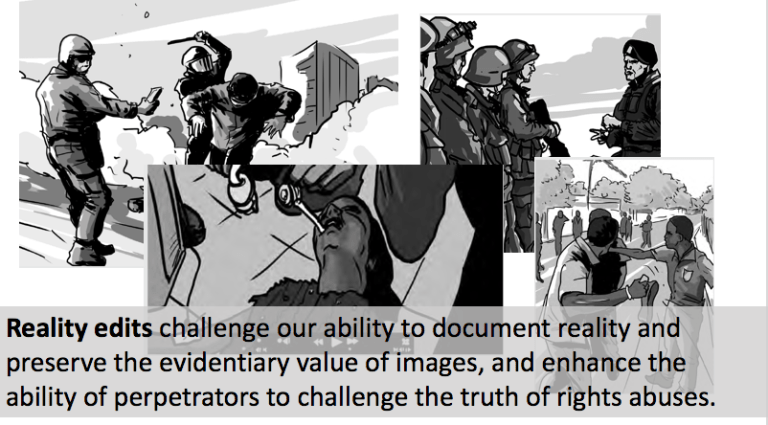

- Ediciones de la realidad eliminando o agregando en fotos y videos de una manera que pone a prueba nuestra capacidad de documentar la realidad y preservar el valor probatorio de las imágenes, y mejora la capacidad de los autores para desafiar la verdad de violaciones de los derechos.

- Doppelgangers creíbles de personas reales que mejoran la capacidad de manipular al público o individuos para cometer abusos de derechos o para incitar a la violencia o el conflicto.

- Remezcla de noticias que aprovechan señales periféricas de credibilidad y el ciclo de noticias rápidas para disrumpir y cambiar las narrativas públicas.

- Negación plausible de los perpetradores a reclamar reflexivamente “Eso es una gran burla” en torno a imágenes incriminatorias, o más allá, a descartar cualquier información impugnada como otra forma de noticias falsas.

- Inundaciones de falsedad creadas a través de propaganda computacional y micro focalización individualizada, que contribuyen a disrumpir la esfera pública restante y a enfoques abrumadores de investigación y verificación de hechos.

Alteraciones de la realidad representan un reto a nuestra capacidad de documentar la realidad y preservar el valor probatorio de las imágenes, y fortalecen la capacidad de perpetradores de cuestionar la verdad sobre abusos a derechos.

¿Por qué WITNESS está comprometido?

Durante más de 25 años, WITNESS ha permitido a los defensores de los derechos humanos, y ahora cada vez más a cualquier persona, en cualquier lugar, utilizar el video y la tecnología para proteger y defender los derechos humanos. Nuestro trabajo y el trabajo de nuestros socios demuestran el valor de las imágenes para generar una narración personal y periodismo cívico más diverso, impulsar movimientos en torno a violaciones generalizadas de los derechos humanos como la violencia policial y ser una evidencia crítica en los juicios por crímenes de guerra. También hemos visto la facilidad con la que videos y audio, a menudo, crudamente editados o incluso simplemente reciclados y re-contextualizados, pueden perpetuar y renovar ciclos de violencia.

El trabajo de WITNESS Tech + Advocacy con frecuencia incluye participar en redes sociales clave y plataformas de intercambio de videos para desarrollar políticas innovadoras y respuestas de productos a los desafíos que enfrentan las personas usuarias de alto riesgo y alto contenido de interés público. A medida que surge la amenaza de manipulación de audio y video más sofisticada y personalizada, nos centramos en la necesidad crítica de reunir a los actores clave antes de que estemos en el ojo de la tormenta, para rechazar las narrativas apocalípticas sobre este tema, e identificar soluciones proactivas para garantizar que nos preparemos de una manera más coordinada.

¿Qué son los Deepfakes y Synthetic Media?

El desarrollo de nuevas formas de síntesis de imágenes y audio está relacionado con el crecimiento del subcampo del aprendizaje automatizado (machine learning) conocido como aprendizaje profundo (Deep learning), que incluye el uso de arquitecturas para inteligencia artificial similares a las redes neuronales humanas. Redes Generativas Antagónicas (RGAs) es la tecnología utilizada en deepfakes. Dos redes neuronales compiten para producir y discernir imágenes falsas de alta calidad. Uno es el “generador” (que crea imágenes que se parecen a una imagen original) y el otro es el “discriminador” (que trata de determinar si una imagen es real o simulada). Compiten en un juego de gato y ratón para obtener mejores y mejores imágenes.

El costo de producir estas nuevas formas de synthetic media ha disminuido significativamente en los últimos años debido a la creciente cantidad de datos de capacitación, poder de cómputo, enfoques y códigos efectivos compartidos públicamente.

Entonces, ¿cómo llamar a estas manipulaciones? Los términos para describir estos avances en la manipulación de audio y video aún no están bien definidos. La conversación actual está dominada por el término deepfakes, que se refiere al resultado del programa que intercambia una cara entre una persona y otra, y que se implementó inicialmente en contextos como la manipulación no consensual de imágenes para pornografía. Pero es posible un rango más amplio de manipulación (y consecuentes usos maliciosos) de audio y video, y se le ha llamado synthetic media.

Herramientas potenciales susceptibles al mal uso incluyen:

- Audio simulado individualizado: la capacidad mejorada de simular voces de individuos, como la desarrollada y disponible comercialmente a través de proveedores tales como Lyrebird o Baidu DeepVoice.

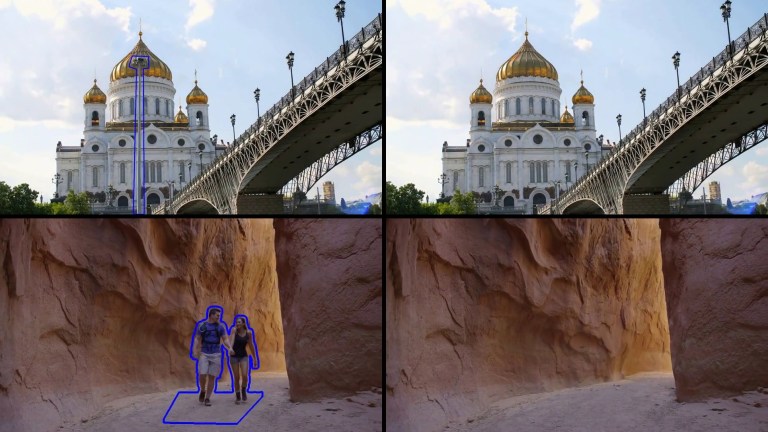

- Nuevas herramientas para el consumidor que facilitan la edición selectiva, la eliminación o el cambio de elementos de primer plano y de fondo en video. Conceptos como Adobe Cloak están avanzando la edición de imágenes actualmente disponible en herramientas como Photoshop o Premiere y competidores como Pixelmator para permitir una mejor edición sin inconvenientes de los elementos dentro del video.

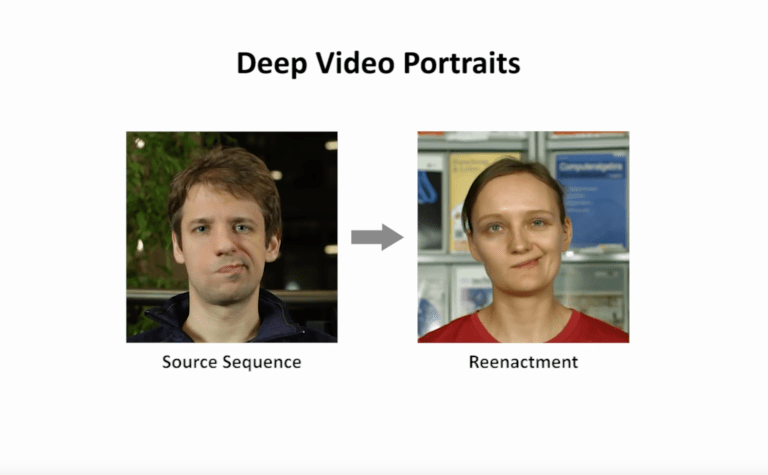

- Recreación facial: Esto se refiere a usar imágenes de personas reales como “marionetas” y manipular sus rostros, expresiones y movimientos de la parte superior del cuerpo. Herramientas como Face2Face y Deep Video Portraits permiten la transferencia de los movimientos faciales y parte superior del cuerpo de una persona a la apariencia realista de la cara y la parte superior del cuerpo de otra persona real.

- Reconstrucción facial realista y sincronización de voz creadas con pistas de audio existentes de una persona, como se ve, por ejemplo, con el proyecto LipSync Obama.

- Personas reales con intercambio de una región, típicamente una cara: más comúnmente visto a través de deepfakes creados con herramientas como FakeApp o FaceSwap. Estos enfoques también se relacionan con tecnologías utilizadas en herramientas de consumo como Snapchat, en las que la simulación de la cara de una persona se impone en la cara de otra persona o en la que se produce una cara híbrida.

- Combinaciones como deepfake emparejado con audio (real o simulado) y retoque adicional, por ejemplo el video de Obama-Jordan Peele en el que el actor y director Jordan Peele hizo que un Obama realista dijera las palabras que el propio Peele estaba diciendo.

Una introducción a la carrera de “armas” entre la síntesis de Synthetic Media y la detección / análisis forense.

Hay una carrera de armamentos en curso entre la síntesis manual y automática de medios, y enfoques forenses manuales y automáticos.

La síntesis manual se caracteriza por el modelado explícito de la geometría, la iluminación y la física que vemos en los efectos de Hollywood. Las CGI han formado parte de la industria del cine durante 30 años, pero requiere mucho tiempo, es costoso y requiere dominio experto. Por otro lado, la síntesis automática implica el uso de síntesis implícita de textura, iluminación o movimiento de la cabeza, como hemos visto, por ejemplo, en LipSync Obama, Deep Video Portraits o, por supuesto, deepfakes. Las técnicas aquí a menudo implican una combinación de visión artificial y computación gráfica, y en algunos casos usos de redes neuronales. Herramientas como LipSync Obama se basan en una trayectoria de investigación de veinte años explorando cómo crear modelos de rostro en 3D a partir de imágenes existentes. Existe una gama de aplicaciones positivas de ‘synthetic media’ mejoradas que incluyen video y telepresencia virtual, VR y AR y creación de contenido, animación y doblaje. También habrá usos en sistemas autónomos y en interacción de persona-computadora / humano-robot.

Los software de edición y la síntesis manual y automática pueden crear cada vez más imágenes perceptualmente realistas, que a simple vista y análisis visuales no son vistas como manipuladas.

El análisis forense manual realiza comprobaciones explícitas de la geometría de la perspectiva, la iluminación, las sombras y la ‘física’ de las imágenes, como también detecta, por ejemplo, la copia y unión entre imágenes y la evidencia del modelo de cámara para una fotografía. Un ejemplo notable reciente de análisis forense manual específico de deepfakes es la idea de usar una técnica conocida como Ampliación de Video de Euleriana, para ver la frecuencia de pulso visible de personas reales que estaría ausente en deepfake.

Un campo emergente es el análisis forense automático. Los enfoques explorados en este incluyen buscar en conjuntos de datos más grandes y utilizar el aprendizaje automático para realizar análisis forense. La experimentación reciente incluye:

- Detección de copia y empalme o uso de dos modelos de cámaras diferentes en imágenes de origen.

- Detección de “mapa de calor” de píxeles falsos en imágenes faciales creadas con FaceSwap.

- Identificación de dónde se originan los elementos de una imagen falsa a través de la filogenia de la imagen.

- Uso de redes neuronales para detectar inconsistencias fisiológicas en synthetic media, por ejemplo, la ausencia de parpadeo.

- Uso de RGAs para detectar imágenes falsas basadas en datos de entrenamiento de imágenes de video sintéticas creadas con herramientas existentes (la base de datos de FaceForensics).

Sin embargo, la mayoría de los sistemas están capacitados sobre bases de datos específicas, y pueden detectar principalmente las inconsistencias de las técnicas de síntesis específicas, aunque hay trabajos en curso que abordan estas deficiencias. También existen nuevos enfoques anti- forense que utilizan RGAs para luchar contra el análisis forense; por ejemplo, borrando las huellas forenses de varias cámaras y creando una imagen que parece tener la firma de cámara uniforme de otra cámara.

Los investigadores no están de acuerdo sobre si la “carrera de armamentos” es probable que sea ganada por los falsificadores o por los detectores. Los humanos no son buenos para detectar la diferencia entre un video real y uno falso, pero las máquinas sí (vea datos en FaceForensics (pdf) que indica que con imágenes de baja resolución los humanos tenían aproximadamente 50% de precisión “lo cual es esencialmente adivinar”). Actualmente, la detección es más fácil que la falsificación y para cada IA de falsificación existe un poderoso modelo de detección. Siempre que haya suficientes datos de entrenamiento que muestren nuevos tipos de imágenes, audio y video fasos, el uso de RGAs podría mantenerse al día para permitir la identificación asistida por IA de falsificación no visible. Puede haber un desfase temporal, que será explotado por los malhechores, pero la detección debería seguir mejorando.

¿Qué está haciendo WITNESS?

Vemos la necesidad de:

- Ampliar la comprensión de los periodistas, tecnólogos e investigadores en derechos humanos sobre estas nuevas tecnologías.

- Empezar a construir un entendimiento común de las amenazas creadas por mal uso de las imágenes, vídeo y audio generados por IA para el discurso público y confiable de noticias y documentación sobre derechos humanos, y trazar mapa del paisaje de innovación en esta área.

- Hacer un mapa de las soluciones que surgen de las prácticas existentes en materia de derechos humanos, periodismo y tecnología para hacer frente al mal uso de imágenes, audio y video simulado y reciclado, y su relación con otras formas de mal/des-información.

- Desarrollar respuestas tácticas, normativas y técnicas pragmáticas apropiadas para modelos de riesgo de audio y video fabricados que puedan ser iniciados por compañías, activistas independientes, periodistas, investigadores académicos, tecnólogos de código abierto y plataformas comerciales.

- Impulsar las prioridades de investigación y acción de las partes claves interesadas.

Para iniciar eso el 11 de junio de 2018, WITNESS en colaboración con First Draft, un proyecto del Centro Shorenstein de Medios, Política y Políticas Públicas en Harvard Kennedy School, reunió a treinta destacados tecnólogos independientes y basados empresas, especialistas en aprendizaje automático, académicos investigadores de synthetic media, investigadores de derechos humanos y periodistas.

Nuestro objetivo era mantener una discusión abierta bajo la regla de Chatham House sobre formas proactivas pragmáticas para mitigar las amenazas que potencialmente suponen para la confianza pública, el periodismo confiable y documentación confiable sobre derechos humanos el uso generalizado y la comercialización de nuevas herramientas de synthetic media generada por IA como deepfakes y recreación facial.

Nuestro informe de convocatoria está disponible aquí y compartiremos los elementos ampliados del informe y más detalles sobre las recomendaciones en blogs separados, que incluyen:

• Deepfakes y Synthetic Media: Encuesta de soluciones sobre usos maliciosos

¿Qué recomendamos como próximos pasos?

Entre las recomendaciones de la convocatoria:

- Investigación básica y una carrera centrada en las formas óptimas para rastrear la autenticidad, la integridad, la procedencia y las ediciones digitales de imágenes, audio y video desde la captura al compartir, al uso continuo. La investigación debe centrarse en un enfoque de protección de derechos que a) maximice la cantidad de personas que pueden acceder a estas herramientas, b) minimice las barreras de entrada y la posible supresión de la libertad de expresión sin comprometer el derecho a la privacidad y la libertad de vigilancia c) minimice el riesgo para creadores vulnerables custodios y los equilibra con d) posible viabilidad de integrar estos enfoques en un contexto más amplio de plataformas, redes sociales y en los motores de búsqueda. Esta investigación debe reflejar la plataforma, los esfuerzos de activistas independientes y de código abierto, considerar el uso de blockchain y tecnologías similares, revisar precedentes (por ejemplo, correo no deseado y esfuerzos anti-desinformación actuales) e identificar los pros y los contras para los diferentes enfoques y también los riesgos imprevistos. WITNESS liderará en el apoyo de esta investigación y carrera.

- Modelos de amenazas detallados en torno a los malos usos de synthetic media para particulares partes clave interesadas (periodistas, defensores de los derechos humanos, otros). Crear modelos basados en actores, motivaciones y vectores de ataque, lo que resultará en la identificación de enfoques personalizados relevantes para partes interesadas específicas o temas / valores en juego.

- Diálogo público y privado sobre cómo las plataformas, los sitios de redes sociales y los motores de búsqueda diseñan un enfoque compartido y se coordinan mejor en torno a los malos usos de Synthetic Media. Al igual que las discusiones públicas sobre uso de datos y moderación de contenido, hay un rol para que terceros en la sociedad civil sirvan como voz pública sobre los pros / contras de varios enfoques, así como para facilitar el debate público y servir como un espacio neutral para la creación de consenso. WITNESS apoyará este tipo de discusión orientada a resultados.

- Las plataformas, las empresas de búsqueda y redes sociales deberían priorizar el desarrollo de las herramientas clave ya identificadas en la comunidad de derechos humanos y periodismo OSINT como críticas; particularmente búsqueda de video inversa. Esto se debe a que muchos de los problemas de Synthetic Media se relacionan con los desafíos existentes en torno a la verificación y la confianza en los medios visuales.

- Más aprendizaje compartido sobre cómo detectar Synthetic Media que reúna prácticas existentes de análisis forense manual y automático con derechos humanos, Open Source Intelligence (OSINT) y profesionales del periodismo, posiblemente a través de un taller donde prueban / aprenden los métodos de los demás y determinan qué adoptar y cómo hacer que las técnicas sean accesibles. WITNESS y First Draft participarán en esto.

- Prepárese para el surgimiento de synthetic media en situaciones del mundo real trabajando con periodistas y defensores de los derechos humanos para construir recursos sobre cómo enfrentar escenarios de riesgo para que nadie pueda decir “no lo vimos venir” y para facilitar una mayor comprensión de las tecnologías en juego. WITNESS y First Draft colaborarán en esto.

- Incluir a más personas interesadas que estaban subrepresentadas en la convocatoria de junio 11, 2018 que son voces críticas ya sea en una reunión adicional o en las próximas actividades que incluyen😮 Las voces del Sur Global y las comunidades marginadas de Estados Unidos y Europa.o Voces políticas y legales a nivel nacional e internacional.o Artistas y provocadores.

- Comprensión adicional de preguntas de investigación relevantes e investigación principal para informar otras estrategias. First Draft liderará investigaciones adicionales.

Para obtener más información sobre el proyecto, póngase en contacto con Sam Gregory, sam@witness.org.