Ante los deepfakes, prepárate ¡No entres en pánico!

Un recuento de recursos sobre los deepfakes, amenazas que plantean, posibles soluciones y la diversidad de sus usos al día de hoy.

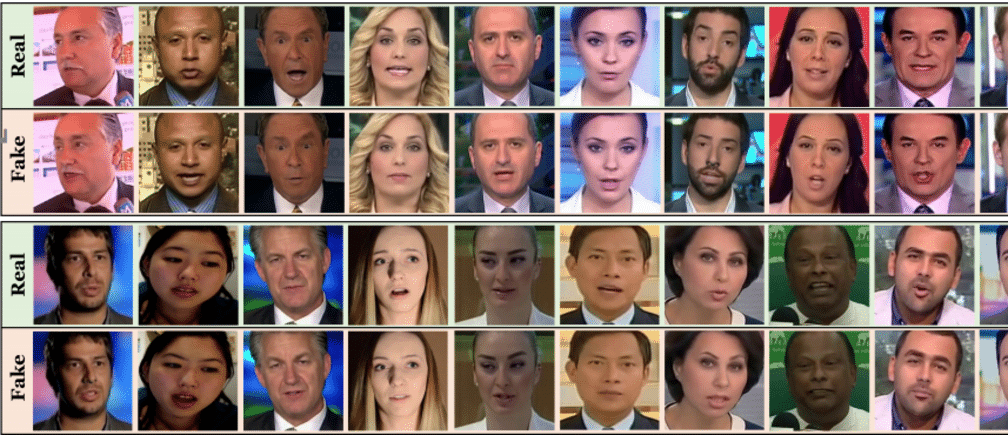

Si sigues las noticias sobre tecnología, seguramente ya habrás escuchado sobre la proliferación de los deepfakes. Como se explica al inicio de este video, los deepfakes son videos que utilizan técnicas sofisticadas de inteligencia artificial para generar escenas que parecerían 100% reales pero que son completamente falsas, como el video de Barack Obama haciendo una crítica a Donald Trump.

El trabajo de WITNESS en torno a los deepfakes inició en 2018, y forma parte de una iniciativa más amplia centrada en enfoques proactivos para defender los derechos humanos a medida que las tecnologías emergentes como la inteligencia artificial se cruzan con amenazas como la desinformación, la manipulación de los medios y el creciente autoritarismo.

“La tecnología es un amplificador de las intenciones humanas… Así como hay buenos usos, también hay muchos malos.” Nina Schick The coming infocalypse durante su participación en la serie de conversatorios Deepfakery

Como parte del trabajo de WITNESS se han realizado encuentros sobre detección de amenazas y priorización de soluciones en Brasil, África Subsahariana, Sur y Sureste de Asia y también en Estados Unidos.

En estos se ha contado con la participación de personas que trabajan en periodismo, libertad de expresión, defensa de derechos humanos, verificación de datos, derechos digitales, realización cinematográfica, justicia internacional, investigación y tecnología.

Entre las preocupaciones, consideraciones, amenazas y soluciones que han surgido de estos encuentros están los siguientes:

- Actualmente, los deepfakes impactan ya de manera abrumadora a las mujeres, a través de la producción de imágenes y videos sexuales no consentidos.

- Una amenaza apremiante para algunxs es el uso de deepfakes por parte del Estado, por ejemplo, para la justificación de actividad policial, para desacreditar a periodistas o activistas, o como chivo expiatorio de activistas por acciones que no habían cometido.

- La preocupación también sobre su uso para incitar a la violencia, la creación de un mundo de “cero confiabilidad” y el impacto en la división social que estos contenidos podrían generar también a través del sesgo confirmatorio dentro de las cámaras de eco en redes sociales.

- Los bajos niveles de alfabetización digital se identificaron también como un problema en el combate de los deepfakes y la desinformación.

- La importancia de identificar e investigar las creencias subyacentes que permiten que la desinformación se propague en nuestras comunidades.

- ¿Existen herramientas qué permitan “esconder” nuestras imágenes para evitar que sean utilizadas para la generación de deepfakes?

- Las herramientas de detección deben ser accesibles (fácil de utilizar y económicas). Más al respecto aquí y aquí.

- Las plataformas como Facebook, Youtube y Google deben ser parte de las soluciones actuando siempre con transparencia.

Esto es solo una pequeñísima muestra de todo lo que ha surgido en los encuentros regionales. Aquí puedes consultar los reportes completos (inglés).

Ante eso, ¿qué podemos hacer? ¡Prepárate! No entres en pánico.

A continuación, compartimos los principios que planteamos como guía para enfrentar los retos que presentan los deepfakes. Como organizaciones de la sociedad civil, este marco puede nutrir nuestras acciones y también las demandas que se hagan a otros actores involucrados:

- Desescalar la retórica y reconocer que esto es una evolución, no una ruptura de los problemas existentes, y que nuestras palabras crean muchos de los daños que tememos.

- Nombrar y abordar los daños existentes de la violencia basada en género y el ciberacoso.

- Inclusión y derechos humanos. Las respuestas a la demanda deben reflejar un enfoque global e inclusivo, así como una visión compartida de los derechos humanos.

- Modelos de amenazas globales. Identificar modelos de amenazas y soluciones deseadas desde una perspectiva global.

- Construir sobre la experiencia existente. Promover enfoques multidisciplinarios y de solución múltiple, aprovechando la experiencia existente en desinformación, verificación de hechos y OSINT.

- Tejido conectivo. Empoderar a los actores/as clave de primera línea, como los medios y los grupos de libertades civiles, para comprender mejor la amenaza y conectarse con otras partes interesadas/expertxs.

- Coordinación. Identificar mecanismos de coordinación apropiados entre la sociedad civil, los medios y las plataformas tecnológicas en torno al uso de medios sintéticos.

- Investigación. Apoyar la investigación sobre cómo comunicar al público la manipulación y simulación de video ‘invisible a la vista’.

- Responsabilidad de la plataforma y de quien desarrolla herramientas. Determinar lo que queremos y lo que no queremos de las plataformas y empresas que comercializan herramientas o actúan como canales de distribución, incluso en términos de herramientas de autenticación, herramientas de detección de manipulación y moderación de contenido en función de lo que encuentran las plataformas.

- Equidad en el acceso a la detección. Priorizar la equidad global en el acceso a los sistemas de detección y abogar porque la inversión en detección coincida con la inversión en enfoques de creación de medios sintéticos.

- Dar forma al debate sobre las opciones de infraestructura y comprender los pros y los contras de qué grupos de personas quedarían incluidas, excluidas, censuradas y empoderadas a nivel mundial por las elecciones que hacemos sobre la autenticidad o la moderación del contenido, y la infraestructura que construimos para esto.

- Promover estándares éticos para el uso en campañas políticas y desde la sociedad civil

Un ejemplo de esto, es la participación de WITNESS en el desarrollo de las especificaciones de la Coalición para la Autenticación y Procedencia del Contenido (C2PA por su nombre en inglés). La C2PA está desarrollando un estándar para comprender la procedencia y las alteraciones en contenidos multimedia, impulsado por varias empresas en conjunto con la intención de impulsar una adopción más amplia. Nuestra participación se ha centrado, mayormente, en el análisis de los posibles daños y abusos que podrían generarse, y cómo reducirlos, eliminarlos o abordarlos (Ver en inglés: Análisis de perjuicios).

Deepfakery: medios sintéticos, arte, derechos humanos, desinformación y periodismo

A mediados de 2020, WITNESS y el Co-Creation Studio del MIT Open Documentary Lab organizaron una serie de conversaciones críticas llamadas Deepfakery. En las charlas participaron personas académicas, cineastas, periodistas, artistas y activistas para hablar de medios sintéticos y su intersección con la sátira, el arte, los derechos humanos, la desinformación y el periodismo.

A mediados de 2020, WITNESS y el Co-Creation Studio del MIT Open Documentary Lab organizaron una serie de conversaciones críticas llamadas Deepfakery. En las charlas participaron personas académicas, cineastas, periodistas, artistas y activistas para hablar de medios sintéticos y su intersección con la sátira, el arte, los derechos humanos, la desinformación y el periodismo.

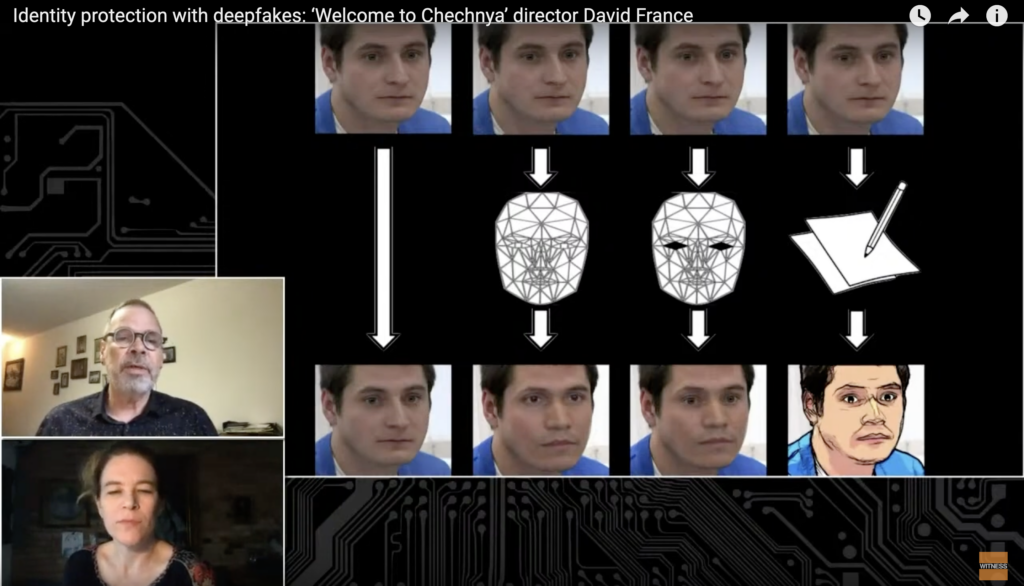

Moviéndonos de los preocupantes escenarios que se han mencionado anteriormente, y que también fueron parte de la serie Deepfakery, en esta serie también se pueden identificar una variedad de usos que se han dado a los medios sintéticos, por ejemplo: el documentalista David France utilizó inteligencia artificial para proteger las identidades de las personas que aparecen en el documental Welcome to Chechnya.

El documental sigue a personas refugiadas en su salida del país a través de una red de refugios. En un país donde las personas LGBT enfrentan graves amenazas, esta tecnología permitió proteger las identidades de quienes fueron capturadxs en video en la grabación del documental.

Estos otros usos vienen como su propia serie de retos, consideraciones y cuidados que deben acompañar la puesta en práctica.

El uso de Deepfakes para hacer un llamado a la justicia

“Quieren amedrentarnos, quieren silenciarnos, quieren detenernos, pero #SeguimosHablando“

Seguimos Hablando es una campaña de Propuesta Cívica, organización que acompaña a familiares de víctimas, periodistas y personas defensoras de derechos humanos que han sido amenazadas, agredidas, desaparecidas, desplazadas y asesinadas por ejercer su labor en México. Esta campaña busca visibilizar la crisis de la libertad de expresión en México y el recrudecimiento de la violencia contra personas periodistas.

Seguimos Hablando es una campaña de Propuesta Cívica, organización que acompaña a familiares de víctimas, periodistas y personas defensoras de derechos humanos que han sido amenazadas, agredidas, desaparecidas, desplazadas y asesinadas por ejercer su labor en México. Esta campaña busca visibilizar la crisis de la libertad de expresión en México y el recrudecimiento de la violencia contra personas periodistas.

La campaña fue lanzada en abril de 2019, “devolviendo la voz” a cuatro de lxs periodistas asesinadxs en México durante 2017: Javier Valdez, Miroslava Breach, Moises Sánchez, José “El Choco” Rodríguez. Quienes denunciaron sus asesinatos a través de sus cuentas de Twitter, con la ayuda de sus familiares y colegas cercanxs.

“Hablar no es fácil y no estaremos en soledad, nuestros familiares están de acuerdo en que escribamos sobre lo que nos pasó; amigos y colegas también retomarán nuestras voz y se creará una conversión indispensable en el marco de un día tan importante a nivel mundial.”

México se ubica en el 6to lugar de impunidad en cuanto a crímenes contra periodistas, de acuerdo con el índice global del Comité para la Protección de los Periodistas, además de registrarse una agresión contra la prensa cada 13 horas en el país.

En este contexto, y a 3 años del asesinato de Javier Valdez, produjeron un video utilizando “los deepfakes como una herramienta para la verdad”. El video fue publicado el 2 de noviembre, Día Internacional para poner fin a la impunidad de los crímenes contra periodistas, y muestra al periodista exigiendo al presidente López Obrador que esclarezca los asesinatos de las y los periodistas cuyos crímenes permanecen impunes.

Javier Valdez fue periodista de investigación, trabajó en La Jornada y cofundó el semanario Ríodoce. El periodista fue asesinado el 15 de mayo de 2017 y “antes de su asesinato tuvo el valor de encarar fuerte y críticamente a Dámaso López Serrano… Javier hizo algo que rara vez ocurre: criticar abiertamente a un narcotraficante”.

Este proyecto se hizo de la mano de Griselda Triana, viuda de Javier Valdez, quien colaboró, desde la aportación de la ropa y objetos personales de su difunto esposo, en la realización del guión, hasta la supervisión de cada detalle. Ella afirma en entrevistas que su esperanza a partir del video es que se ponga un alto a los asesinatos, amenazas e intimidaciones, que las personas periodistas que se encuentran desaparecidas sean encontradas.

Este tipo de resurrection deepfakes puede resultar problemático éticamente. Ante preguntas que surgen sobre: ¿cómo se maneja el consentimiento? Este caso podría mostrarnos algunos de los cuidados a considerar en este tipo de producción:

- La labor de la organización Propuesta Cívica y su trabajo en conjunto con familiares y colegas involucrándoles a lo largo de todo el proyecto, así como activamente durante su difusión.

- El mensaje que se da con este video está directamente relacionado con el mismo periodista Javier Valdez y lo que él ya había denunciado en vida, como fue percibido por algunos medios “en el cumplimiento de sus funciones para informar sobre la violencia y corrupción que se vive en México”.

- La creciente estigmatización a personas periodistas y medios, e incluso contra organizaciones que les apoyan, por parte de la presidencia de la república, con lo que al dar voz a Javier Valdez, se entrega un poderoso mensaje sin poner los reflectores (y el riesgo) en otras personas.

Ante estos usos de deepfake enfocados a la memoria, a apoyar la búsqueda de justicia, se requiere seguir planteando lineamientos éticos. Los cuidados y constantes cuestionamientos deben venir siempre acompañando los usos para dentro de campañas de derechos humanos. Mientras tanto, debemos también seguir la pista de cómo evolucionan las tecnologías y seguimos preparándonos para los otros usos de los deepfakes.

En diciembre del 2021 se publicó el reporte Just Joking! Deepfakery, Satire and the Politics of Synthetic Media una colaboración entre WITNESS y el Co-Creation Studio en el Open Documentary Lab del MIT. Aquí puedes consultar y descargar un resumen en español. En este reporte se incluye una gran variedad de ejemplos de uso de deepfakes y factores que pueden dejar a muchas personas “sin entender el chiste” en las intersecciones de la sátira y la desinformación. Frente a los retos éticos de democratizar la producción de medios sintéticos, como el consentimiento y los impactos diferenciados entre grupos poblacionales y regiones, Just Joking propone una serie de cuestionamientos que buscan ayudar a navegar y prevenir daños.

A continuación, encontrarás una serie de recursos elaborados por WITNESS para seguir adentrándose en el mundo de los deepfakes (actualmente la gran mayoría se encuentran solo en inglés):

Recursos

- Página principal Prepárate, ¡No te paniquees!: Medios sintéticos y Deepfakes

- Adelantarse a una crisis: habilidades de detección de deepfakes + acceso global a herramientas forenses para multimedia

- Videos “Tracing Trust” en Youtube acerca de infraestructura de autenticación

- Reporte “Ticks or it didn’t happen* sobre dilemas presentes en la infraestructura de autenticidad para multimedia

- Siguiéndole el rastro a la confianza: por qué debemos construir una infraestructura de autenticidad que funcione para todxs

- Nuestro análisis sobre la Iniciativa de autenticidad de contenido de Adobe para la infraestructura de autenticidad contra la manipulación de multimedia

- Serie de conversatorios Deepfakery sobre sátira, derechos humanos, arte y periodismo en tiempos de infodemias

- Informe Just Joking de WITNESS y el Co-Creation Studio en el Open Documentary Lab del MIT. Aquí el resumen en español.

- Reportes de encuentros en Brasil, Sur y sureste de Asia, África Subsahariana y Estados Unidos.