Hacia herramientas de detección de IA equitativas y eficaces: Un llamado en favor de normas que sirvan a todas las comunidades

Escrito en su versión original en inglés por shirin anlen, traducción por Indira Cornelio

A medida que evoluciona la tecnología de IA generativa, también lo hacen las herramientas diseñadas para detectarla. Sin embargo, en la carrera por desarrollar sistemas de detección de alto rendimiento, se corre el riesgo de pasar por alto un elemento crítico. La eficacia suele medirse a través de parámetros técnicos: precisión, velocidad, escalabilidad y versatilidad. Aunque estas métricas son importantes, no logran captar todas las complejidades del uso en el mundo real. En WITNESS, hemos observado sistemáticamente una notable brecha entre las capacidades técnicas de las herramientas de detección de IA y su valor práctico en situaciones de alto riesgo en el mundo. Esta brecha de equidad en la detección es más pronunciada en el mundo de la Mayoría Global.

Desde marzo de 2023, WITNESS lidera el Grupo de Respuesta Rápida para Deepfakes (DRRF por su nombre en inglés), una iniciativa pionera que conecta a personas verificadoras de información y periodistas con personas expertas en análisis forense de medios y detección de deepfakes. Esta colaboración proporciona un análisis oportuno y detallado de los contenidos que amenazan la democracia y los derechos humanos. Además, a través de la formación impartida a periodistas sobre detección y respuesta a la IA durante el año pasado, hemos observado de primera mano los desafíos agravados que enfrentan lxs actorxs sociales del sur global: ecosistemas mediáticos frágiles, herramientas de detección ineficaces debido a las lagunas en los datos de entrenamiento en idiomas locales, acentos, figuras públicas y tendencias de manipulación, junto con lagunas generalizadas en la alfabetización mediática de la IA que limitan la capacidad de interpretar y confiar en los resultados de la detección.

Desde la lucha contra la desinformación impulsada por la IA hasta la salvaguarda de los derechos humanos, estos retos exigen algo más que solidez técnica: requieren una evaluación más amplia y holística. Aquí es donde el concepto de eficacia equitativa resulta crucial. Exige marcos de evaluación que vayan más allá del laboratorio y tengan en cuenta las realidades sociotécnicas en las que operan estas herramientas. Para las personas usuarias directas -periodistas, defensorxs de los derechos humanos, verificadorxs y la sociedad civil en general- que se enfrentan a la desinformación, las herramientas de detección deben hacer algo más que ofrecer resultados impresionantes en entornos controlados. Deben proporcionar información práctica y fiable en las condiciones impredecibles y de recursos limitados del mundo real.

Los errores del mundo real ponen de relieve lo que está en juego en la eficacia equitativa. En un caso, el DRRF recibió una supuesta grabación de una conversación por radio durante la guerra civil de Sudán. La verificación fue imposible porque los modelos de detección carecían de datos de entrenamiento específicos para «conversaciones de radio». En otro caso, también procedente de Sudán, una supuesta conversación filtrada entre el Comandante y el Jefe del Estado Mayor del Ejército sudanés quedó sin analizar porque los equipos disponibles eran incapaces de procesar contenidos en árabe. En Filipinas, un video de baja resolución en el que supuestamente aparecía el presidente esnifando cocaína planteó otro problema. La mala calidad del video hizo ineficaces las herramientas de detección de IA. Del mismo modo, lxs periodistas de México que analizaron dos imágenes -una original y otra manipulada- se encontraron con resultados contradictorios de los detectores en línea, y uno de ellos identificó falsamente la imagen auténtica como generada por IA. Sólo después de utilizar las herramientas avanzadas del DRRF pudieron confirmar la manipulación. Las incoherencias entre varias herramientas son frecuentes. En algunos casos del DRRF, distintos detectores ofrecieron resultados diferentes para el mismo contenido. Proporcionar contexto a lxs usuarixs, como el informarles sobre los tipos de manipulación que una herramienta está diseñada para detectar y cómo los problemas de calidad pueden afectar a los resultados, puede hacer que incluso los resultados incoherentes sean valiosos.

Lo técnico frente a lo práctico

Para determinar si una herramienta es realmente eficaz, debe ajustarse no sólo a normas técnicas rigurosas, sino también a las realidades prácticas a las que se enfrentan quienes la utilizan. Estos agentes a menudo operan con recursos limitados, lidiando con contenidos de baja calidad o amenazas urgentes. La eficacia equitativa implica abordar seis consideraciones básicas:

- Retos del mundo real: El DRRF ofrece una valiosa perspectiva de estos retos, en los que, con muchos de los casos remitidos a personas expertas forenses en medios de comunicación y en detección de medios sintéticos, hemos observado que las herramientas de detección de IA funcionan mejor con materiales de alta resolución, casi originales y claros. Sin embargo, la realidad es que gran parte del contenido que analizan -a menudo procedente de las redes sociales- viene en formatos comprimidos, ruidosos y de baja resolución. Los archivos de audio con ruido de fondo o de baja calidad suelen arrojar resultados poco concluyentes. Las herramientas deben estar diseñadas para adaptarse a estas condiciones imperfectas, o lxs usuarixs directxs deben estar equipadxs con recursos complementarios para navegar por casos impredecibles.

- Transparencia y explicabilidad: Las herramientas de detección suelen ofrecer resultados binarios acompañados de puntuaciones de confianza, pero por sí solas son insuficientes. Para que los resultados sean procesables y fiables, las herramientas también deben ofrecer información adicional, como: orientación sobre la interpretación de los resultados, los tipos de manipulaciones que la herramienta fue entrenada para detectar, información sobre el conjunto de datos utilizado para el entrenamiento, y las limitaciones de la herramienta, incluyendo cómo la calidad del contenido puede influir en los resultados. En el vertiginoso panorama actual de los medios de comunicación, esta transparencia permite a periodistas y a verificadorxs navegar por los resultados y elaborar informes basados en pruebas, lo que genera confianza en los resultados de la herramienta.

- Accesibilidad: La excelencia técnica no tiene sentido si las herramientas son inaccesibles para diversas comunidades. Por ejemplo, persisten las barreras lingüísticas, ya que muchas herramientas se utilizan principalmente en inglés y español, lo que limita su utilidad para otros idiomas, acentos y tonos de piel. Además, las herramientas que requieren conocimientos o recursos informáticos avanzados corren el riesgo de excluir a usuarixs de zonas con pocos recursos. La simplificación de las interfaces y el suministro de información práctica y en profundidad son pasos fundamentales para garantizar que estas herramientas sirvan a un público más amplio y se ajusten a una capacidad periodística más amplia.

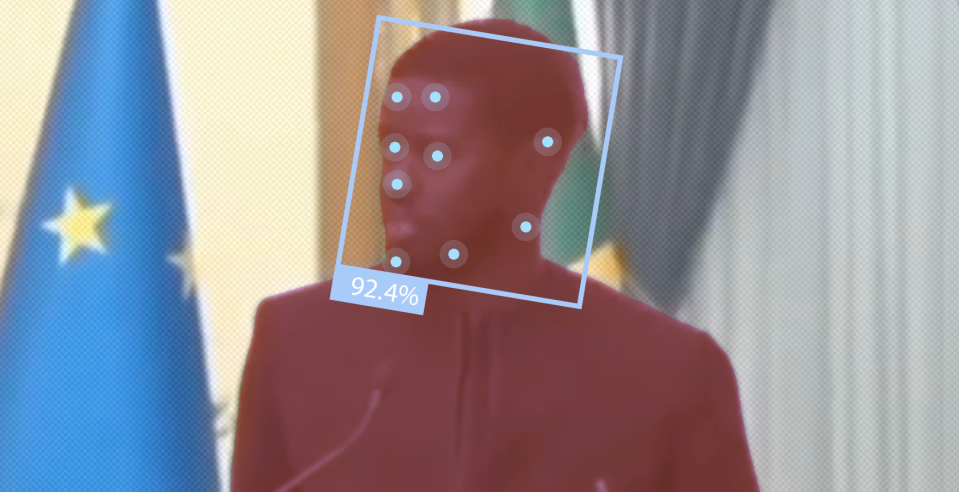

- Equidad: La imparcialidad de las herramientas de detección depende de la imparcialidad de sus datos de entrenamiento. La composición demográfica de los conjuntos de datos de entrenamiento afecta significativamente al rendimiento de las herramientas. Por ejemplo, investigadorxs de la Universidad del Sur de California descubrieron que los conjuntos de datos de detección de falsificaciones más populares estaban compuestos predominantemente por rostros caucásicos. Este desequilibrio se tradujo en un peor rendimiento de los contenidos con otras características demográficas. Garantizar datos de entrenamiento diversos y representativos es esencial para lograr resultados de detección justos y precisos.

- Durabilidad: A medida que la tecnología deepfake evoluciona rápidamente, las herramientas de detección deben seguir el ritmo. Las herramientas deben diseñarse teniendo en cuenta la adaptabilidad, y ser capaces de responder a los rápidos cambios en el panorama de las técnicas generativas. Las actualizaciones periódicas, el mantenimiento y la comunicación pública sobre estos cambios son cruciales para garantizar que estas herramientas sigan siendo eficaces contra manipulaciones cada vez más sofisticadas. Sin un perfeccionamiento continuo, incluso las herramientas más avanzadas corren el riesgo de quedarse obsoletas, dejando a lxs usuarixs vulnerables ante las nuevas amenazas.

- Contextualización con otros conjuntos de competencias: Las herramientas de detección de IA se aplican con frecuencia a contenidos complejos e impredecibles, por lo que confiar en ellas como soluciones independientes suele quedarse corto. En su lugar, cuando sea posible, estas herramientas deben considerarse parte de un proceso de verificación más amplio y no una solución completa.

Un marco para la eficacia equitativa de la detección de la IA

En respuesta, WITNESS está desarrollando un marco para evaluar las herramientas de detección de IA basado en estos seis principios que priorizan la equidad y el contexto social. Construido a partir de las ideas recogidas a través de nuestro trabajo con el Grupo de Respuesta Rápida Deepfakes e informado por las consultas con personas verificadoras, especialistas forenses AI, y defensorxs de los derechos digitales, este marco se centra en preguntas orientadoras diseñadas para asegurar que estas herramientas sirven a las comunidades que más lo necesitan. Va más allá de los puntos de referencia puramente técnicos para tener en cuenta las experiencias vividas por quienes utilizan estas herramientas para contrarrestar la desinformación a diario.

La eficacia equitativa requiere plantearse preguntas críticas, entre ellas:

- ¿Cuáles son los resultados previstos de la utilización de esta herramienta?

- ¿Qué consecuencias imprevistas podrían surgir?

- ¿Pueden las personas usuarias comprender los resultados y confiar en ellos?

- ¿Las herramientas son accesibles y asequibles para diversxs usuarixs?

- ¿Con qué eficacia se comunican a lxs usuarixs las limitaciones de la herramienta?

- ¿Qué información adicional proporciona la herramienta para apoyar el uso responsable y la presentación de informes sobre la IA?

- ¿En qué medida complementa eficazmente un enfoque de detección a otros conocimientos pertinentes ya existentes?

- ¿Se mitigan adecuadamente los sesgos para garantizar resultados fiables en diferentes contextos?

Si tenemos en cuenta estas consideraciones, podremos garantizar que las herramientas de detección de la IA no sólo son técnicamente sólidas, sino también equitativas y eficaces en la práctica.

Una oportunidad para las normas del mundo real

Más allá del desarrollo de herramientas, este marco puede servir de base para conversaciones políticas cruciales. Mientras las personas que legislan y regulan estudian mandatos sobre transparencia y detección de IA, un marco equitativo podría dar forma a las normas de cumplimiento del futuro. Al centrarnos en las necesidades de las diversas comunidades que existen en los ecosistemas de información y desinformación, podemos influir en las prácticas de desarrollo de la IA y establecer normas justas y eficaces para todo el ecosistema, garantizando que las herramientas de detección cumplan su propósito: salvaguardar la verdad y proteger los derechos humanos.

Nos encontramos en un momento crucial. El futuro de la detección de la IA debe guiarse por valores que reflejen las realidades vividas por las personas afectadas por sus fallos. El marco de WITNESS no es sólo una guía para crear herramientas de detección más justas, es un llamado a un campo de la IA que defienda los principios de equidad, inclusión y responsabilidad en cada etapa del diseño y despliegue de la tecnología.

Publicado en su versión origial en inglés el 19 de noviembre de 2024